De Turing et son jeu d’imitation à AlphaGo Zero, la recherche autour de l’intelligence artificielle a été jalonnée de petits pas, de retours en arrière et de grandes découvertes. Bien que ce champ n’en soit qu’à ses débuts par rapport au potentiel qu’on lui prédit, un bref retour sur les dates marquantes permet de mieux comprendre pourquoi et comment nous en sommes aujourd’hui à nous dire que l’ordinateur pourrait un jour dépasser l’humain.

Sommaire :

- 1950 : Alan Turing

- 1956 : John McCarthy

- 1957 : Frank Rosenblatt

- 1966 : Shakey the Robot

- 1968 : Le programme SHRDLU

- 1972 : Le système HEARSAY

- 1987 : Yann Le Cun

- 1997 : Deep Blue

- 2005 : Stanford Racing

- 2016 : AlphaGo

1950 : Alan Turing, chercheur et mathématicien britannique, imagine la machine intelligente. Il expose dans son article “Machines de calculs et intelligence” publié en 1950 dans “Mind” son “jeu de l’imitation”. Ce jeu permettait de répondre à la question “Les machines peuvent-elles penser?”. Dans ce jeu, deux joueurs sont d’identité inconnue (un homme et une machine), un troisième joueur (l’interrogateur) doit poser une série de questions à chacun des joueurs afin de distinguer l’homme de la machine, sachant que chacun des joueurs peut mentir dans sa réponse.

Alan Turing donnait une cinquantaine d’année avant que les machines soient suffisamment perfectionnées pour parvenir à tromper l’interrogateur et le faire échouer dans sa distinction correcte entre homme et machine.

1956 : John McCarthy propose pour la première fois le terme d’intelligence artificielle dans le programme du séminaire ayant eu lieu à Dartmouth du 18 juin au 17 août 1956. Cet événement marque le début des recherches sur l’intelligence artificielle devant une audience d’une vingtaine de personnes, dont seulement six chercheurs qui ont assisté à l’intégralité des débats.

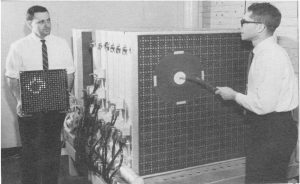

1957 : Frank Rosenblatt, psychologue américain, s’implique dans la recherche sur l’intelligence artificielle en s’appuyant sur le fonctionnement neuronal, il est le principal représentant du “courant neuronal” pour l’intelligence artificielle. A partir des travaux des neurologues Warren S. McCulloch and Walter Pitts de 1943 sur la modélisation mathématique du fonctionnement d’un neurone isolé (le neurone formel), il développe avec Charles Wightman en 1957 le Perceptron Mark I.

Cette machine a pour but de percevoir et reconnaître des lettres de l’alphabet. Pour cela, une lettre est exposée à des cellules photoélectriques (premier plan sur la photo), puis traduite en impulsion électrique jusqu’à l’écran de présentation composé de lumières qui vont former la lettre perçue. Les neurones artificiels contenus entre ces cellules de perception et d’action font le choix ou non d’activer la lumière finale en fonction de la somme des informations obtenue. Si une lumière s’allume alors qu’elle n’aurait pas dû s’allumer, les neurones artificiels vont diminuer le poids donné à cette connexion et ainsi apprendre de ses erreurs. Au même titre que si la lumière ne s’allume pas alors qu’elle aurait dû s’allumer, les neurones artificiels vont augmenter le poids donné à cette connexion et améliorer la performance de perception.

1966 : Le projet Shakey the Robot a commencé à être mis en place à partir de 1966 jusqu’à 1972. Ce projet était coordonné par Charles Rosen, un scientifique américain, pionnier dans le domaine de l’intelligence artificielle. Le robot Shakey est le premier robot mobile, capable de combiner du raisonnement logique et des actions physiques.

Pour la partie des actions physiques, Shakey dispose d’un panel d’actions dans son programme telles que : se déplacer d’un endroit à un autre, pousser des objets mobiles, monter ou descendre des objets fixés, lever ou baisser l’interrupteur, ouvrir ou fermer des portes.

Pour la partie du raisonnement, Shakey bénéficie d’un planificateur automatisé, le STRIPS (Stanford Research Institute Problem Solver). C’est à dire que selon un but donné, le STRIPS va organiser les actions pour pouvoir aboutir au but demandé.

Par exemple, si la commande de l’opérateur est de “pousser le bloc de la plateforme”, Shakey va analyser son environnement, trouver la plateforme sur laquelle il y a un bloc, organiser l’ensemble des actions lui permettant de pousser le bloc de la plateforme (trouver une rampe pour atteindre la plateforme, la déplacer jusqu’à la plateforme, monter sur la rampe, pousser le bloc de la plateforme).

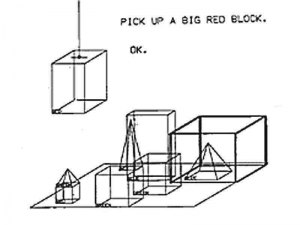

1968 : Le programme SHRDLU, est une avancée et une simplification majeure de l’interaction homme-machine. Ce programme permet un dialogue interactif entre un utilisateur et un robot. Ce programme permet de combiner quatre idées différentes et une cinquantaine de mots différents décrivant l’environnement (cubes, cônes, bleu, vert …) et les actions possibles (prendre, poser sur, déplacer, trouver…)

Vous trouverez ci-après un exemple du dialogue utilisé pour la démonstration de SHRDLU :

Person: PICK UP A BIG RED BLOCK.

Computer: OK. (does it)

Person: GRASP THE PYRAMID.

Computer: I DON’T UNDERSTAND WHICH PYRAMID YOU MEAN.

Person: FIND A BLOCK WHICH IS TALLER THAN THE ONE YOU ARE HOLDING AND PUT IT INTO THE BOX.

Computer: BY « IT », I ASSUME YOU MEAN THE BLOCK WHICH IS TALLER THAN THE ONE I AM HOLDING.

Computer: OK. (does it)

Person: WHAT DOES THE BOX CONTAIN?

Computer: THE BLUE PYRAMID AND THE BLUE BLOCK.

Person: WHAT IS THE PYRAMID SUPPORTED BY?

Computer: THE BOX.

Person: HOW MANY BLOCKS ARE NOT IN THE BOX?

Computer: FOUR OF THEM.

Person: IS AT LEAST ONE OF THEM NARROWER THAN THE ONE WHICH I TOLD YOU TO PICK UP?

Computer: YES, THE RED CUBE.

Person: IS IT SUPPORTED?

Computer: YES, BY THE TABLE.

Person: CAN THE TABLE PICK UP BLOCKS?

Computer: NO.

Person: CAN A PYRAMID BE SUPPORTED BY A BLOCK?

Computer: YES.

1972 : Le système HEARSAY développé par le département d’informatique de l’Université de Carnegie Mellon est le premier système permettant d’effectuer de la reconnaissance vocale. L’analyse du langage oral par le système HEARSAY réussit la prouesse technologique de combiner à la fois l’aspect lexical, syllabique, phonémique et les sous-segments du langage.

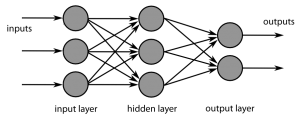

1987 : Yann Le Cun, chercheur français en intelligence artificielle et en vision artificielle, soutient sa thèse sur les modèles connexionnistes de l’apprentissage. Les premiers réseaux de neurones artificiels (ou perceptrons) étaient limités à une résolution de problèmes linéaires.

La variante qu’il expose dans sa thèse propose d’empiler plusieurs Perceptrons et d’aboutir à un perceptron multicouche afin d’améliorer les performances d’apprentissage de ces réseaux de neurones. Ainsi, à l’aide de plusieurs couches de neurones artificiels et grâce à la rétropropagation, les modifications seront plus significatives sur les liaisons qui entraînent une erreur majeure et seront moins importantes pour des erreurs marginales. Chaque neurone d’une même couche est relié à l’ensemble de la couche suivante. L’importance de pondérer chacune des liaisons prend ici tout son sens et permet un apprentissage plus fin.

Grâce à cette technique d’apprentissage en profondeur, il est considéré comme le père fondateur de l’apprentissage profond (le deep-learning).

Il développe notamment un algorithme permettant la reconnaissance visuelle des écritures manuscrites à destination de la lecture des montants des chèques et d’en proposer la vérification automatique.

1997 : Le champion du monde d’échec Garry Kasparov s’incline face au supercalculateur d’IBM “Deep Blue” au bout de 6 parties. Ce match est en fait un match revanche ayant eu lieu l’année précédente qu’avait remporté Garry Kasparov.

Le projet Deep Blue, est l’aboutissement d’un projet d’un ordinateur d’échec ChipTest conçu en 1985 par Feng-hsiung Hsu, Thomas Anantharaman et Murray Campbell à l’Université Carnegie-Mellon.

Le supercalculateur Deep Blue peut calculer jusqu’à 200 millions de positions par seconde. Il a été élaboré à l’aide de consultants grand maîtres qui ont évalué les positions des pièces sur l’échiquier. Ces évaluations ont été alors traduites par les programmeurs Feng-hsiung Hsu, Thomas Anantharaman et Murray Campbell afin d’optimiser la réussite de Deep Blue.

2005 : l’équipe Stanford Racing de l’Université Stanford en collaboration avec le laboratoire de recherche en électronique de Volkswagen a participé à la course DARPA Grand Challenge en 2005 en proposant Stanley, un véhicule autonome. Ce véhicule autonome était truffé de capteurs lui permettant une analyse optimale de son environnement. Il était notamment surmonté de caméras lui permettant de modéliser son environnement en 3D, un système de guidage GPS, des gyroscopes, des accéléromètres ainsi qu’une caméra permettant une bonne vision des conditions de conduite à 80m. Ce premier véhicule autonome a d’ailleurs remporté la course et le prix de deux millions de dollars !

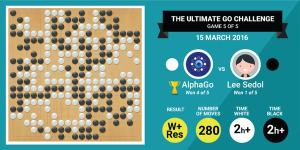

2016 : Dans la même lignée de faire s’affronter intelligence humaine et intelligence artificielle, Google a développé AlphaGo. Ce supercalculateur devient maître du go en mars 2016 en battant le champion du jeu de go Lee Sedol.

A la différence d’un jeu d’échec, le jeu de go propose un nombre incalculable de mouvements et placements sur le plateau. Pour réussir à combiner stratégie, logique et créativité, AlphaGo s’est appuyé sur de l’apprentissage profond (deep-learning).

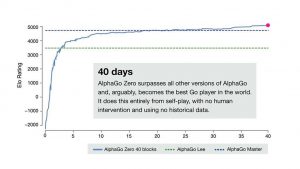

L’année suivante, AlphaGo Zero, une nouvelle version d’AlphaGo s’est révélée beaucoup plus performante à la fois dans l’apprentissage du jeu de Go en lui-même mais également dans les performances résultantes de l’apprentissage allant jusqu’à battre son prédécesseur au bout de 3 jours d’apprentissage.

AlphaGo Zero a construit l’ensemble de son apprentissage sur uniquement deux choses : les règles du jeu de go et la position des pièces sur le plateau. Le reste de son apprentissage, notamment les stratégies à utiliser et l’appropriation du jeu, s’est fait au fur et à mesure des parties que l’intelligence artificielle a jouées contre elle-même, sans intervention humaine.

AlphaGo Zero a notamment trouvé de nouvelles manières de jouer à ce jeu qui passionne depuis plusieurs millénaires des joueurs humains.

Pour aller plus loin :

- https://youtu.be/ALQ_RNSRE40

- Le film “Imitation Game” de 2015

- https://www.lesechos.fr/idees-debats/dossiers/intelligence-artificielle-IA-Gafa-AlphaGo-Watson/010175528502-1957-le-perceptron-premiere-machine-apprenante-2108927.php

- http://www.college-de-france.fr/site/yann-lecun/inaugural-lecture-2016-02-04-18h00.htm

- https://www.francetvinfo.fr/replay-radio/nouveau-monde/nouveau-monde-du-samedi-20-octobre-2018-le-cerveau-biologique-est-bien-en-avance-sur-le-cerveau-numerique-yann-le-cun-facebook_2987523.html?fbclid=IwAR1a6S4nOEK03OdSOZNEtDMUNYbhejH2KZnvwN3KSDeGwiW8tFZaR4z9Rvw